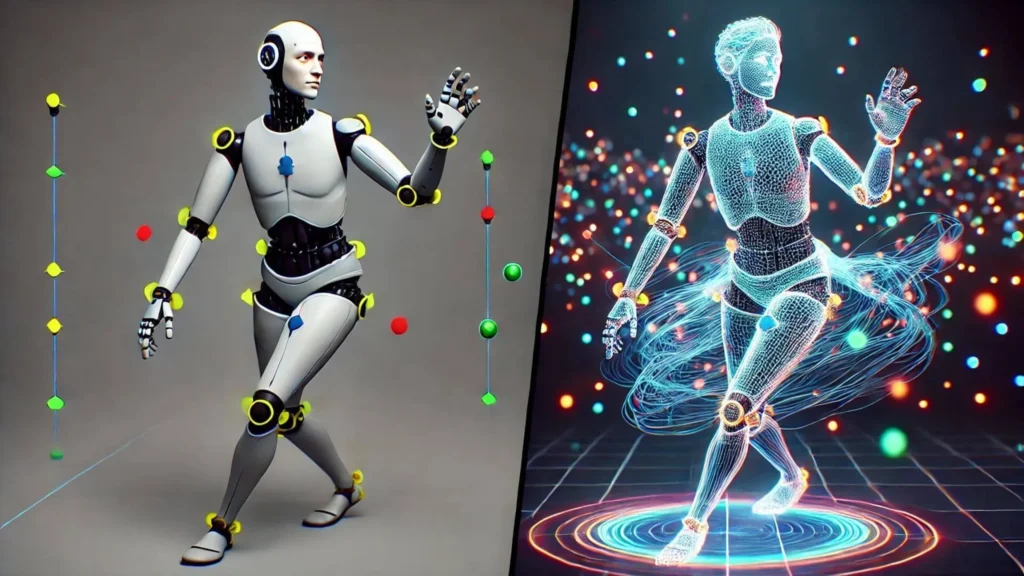

Qué es el aprendizaje por imitación en humanoides

El aprendizaje por imitación en humanoides (LfD) es un enfoque en el que el robot aprende políticas observando demostraciones expertas y extrayendo de ahí la relación estado→acción para resolver tareas de manipulación, marcha y tareas compuestas. Es un campo con décadas de trabajo y encaja perfecto con humanoides porque reduce ingeniería manual de control para tareas variables.

Aprendizaje por imitación en humanoides

Por qué funciona (y cuándo no)

Funciona cuando tu tarea tiene estructura y puedes recolectar ejemplos representativos de los estados que el robot encontrará. Falla cuando:

- Hay desplazamiento de distribución (el robot se sale de los estados vistos y se pierde).

- Las demos son pobres o inconsistentes.

- La tarea exige razonamiento a largo plazo con señales de recompensa escasas.

El antídoto está en cerrar el bucle: correcciones en línea (DAgger), data augmentation, y validación continua del desempeño.

Métodos clave: de clonado a DAgger y GAIL

Behavior Cloning (clonado)

Se entrena un modelo supervisado con pares (estado, acción). Es la base del aprendizaje por imitación en humanoides, pero sufre de compounding errors (errores se acumulan cuando el robot deriva).

DAgger (Ross et al.)

DAgger mezcla ejecución del alumno y correcciones del experto para cubrir estados “raros”. Reduce el desvío y mejora mucho la robustez en despliegue. Es uno de los pilares prácticos cuando aplicas aprendizaje por imitación en humanoides a tareas reales.

IRL y GAIL (Ho & Ermon)

En lugar de copiar acciones, infiere la función de coste (IRL) o imita de forma adversarial (GAIL), aprendiendo políticas que se comportan como el experto sin necesidad de recompensas manuales. GAIL es un estándar moderno cuando necesitas generalización con menos demos “perfectas”.

Híbridos modernos

Combinaciones con self-supervision, foundation models multimodales, o skills libraries para componer habilidades. El patrón: primero imita, luego refina con objetivos (RL, constraints, seguridad).

Cómo recoger buenas demostraciones (humanoides)

- Kinesthetic teaching (guiado kinestésico): mueves físicamente brazos/manos del humanoide; capta trayectorias y fuerzas sin transferencias de cinemática entre sistemas. Oro puro para manipulación fina.

- Teleoperación (VR/joystick) con retroalimentación visual/háptica.

- Demostración en vídeo + pose estimation (si no puedes manipular el robot).

- Segmentación por subtareas (abrir puerta, asir pomo, traccionar).

- Cobertura de estados: incluye casos feos (iluminación, ángulos malos, objetos cambiados).

Reúne 10–50 demos buenas por subtarea al empezar; añade más donde veas fallos.

Pipeline de datos y entrenamiento

- Definición de observaciones: RGB-D en cabeza y muñeca, tacto en dedos, estado articular e IMU.

- Sincronización y limpieza: time stamps, outliers, normalización.

- Etiquetado/segmentación de fases (alcance, cierre, extracción, verificación).

- Entrenamiento inicial con clonado + augmentations (ruido, cambios de luz).

- DAgger: despliegas en entorno seguro, recoges correcciones del experto y reentrenas.

- GAIL/IRL si necesitas políticas que emulen distribución completa del experto.

- Validación en benchmarks internos (éxito por intento, tiempo de ciclo, calidad del agarre).

- Despliegue controlado con gates de seguridad y telemetría.

Métricas que mandan (KPIs)

- Tasa de éxito por subtarea y tarea compuesta.

- Tiempo de ciclo y varianza.

- Calidad de agarre (resbalón, fuerza, reposición).

- Robustez: éxito bajo cambios de luz/fondo/objetos.

- Seguridad: paradas por contacto no previsto, límites de fuerza (si hay colaboración).

Riesgos habituales y cómo evitarlos

- Desplazamiento de distribución → DAgger + curriculum + domain randomization.

- Demos ruidosas → filtra y regraba outliers; usa medianas/SMOOTH.

- Sobreajuste a un operador → mezcla demostradores y entornos.

- Falta de táctil → añade sensores en dedos/mano para cerrar bucle de fuerza.

- Olvido catastrófico al reentrenar → replay buffers y regularización.

Checklist de despliegue (de demo a producción)

- Caso de uso en una línea y KPIs medibles.

- Protocolo de demos (nº, diversidad, escenarios “feos”).

- Plan DAgger (quién corrige, durante cuántas iteraciones).

- Validación con “hold-out de entorno” (luz/objetos nuevos).

- Seguridad: límites de fuerza/energía y evaluación de riesgos (si hay convivencia).

- Telemetría y rollback de modelos.

- Plan de datos: propiedad, retención y anonimización.

Si tu objetivo es llevar un humanoide de demo a turno útil, el aprendizaje por imitación en humanoides es el trampolín: clona, corrige con DAgger, generaliza con GAIL y mide KPIs sin autoengaños. Para profundizar: la encuesta de Argall (fundamentos), DAgger (reducción a no-regret) y GAIL (imitación adversarial).

Si te apasiona la robótica y quieres seguir aprendiendo

¿Qué es la robótica humanoide?

Anatomía de un robot humanoide

Team Evolupedia

Preguntas frecuentes

Depende de la complejidad. Para tareas simples de manipulación, decenas pueden bastar; para tareas largas y compuestas, hablamos de cientos. La clave es cubrir estados difíciles, no grabar mil veces lo mismo.

En la práctica, sí mejora robustez al cubrir estados “raros”, pero requiere protocolo de corrección y tiempo de experto.

Cuando el entorno es complejo y quieres comportamiento tipo experto sin diseñar recompensas, GAIL es potente. Requiere más computación y cuidado en la estabilidad del entrenamiento

Totalmente. Patrón clásico: imita para arrancar y refina con RL donde importa la recompensa (calidad, tiempo de ciclo).